Mặt trái của công nghệ hiện hữu rõ hơn bao giờ hết: một video deepfake có thể tiêm nhiễm những suy nghĩ lệch lạc vào người không hiểu chuyện.

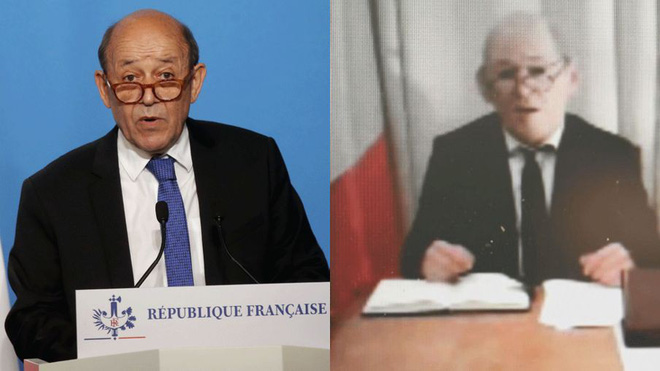

Cách đây không lâu, người ta lật tẩy mánh lới lừa đảo tưởng chừng như chỉ xuất hiện trong Nhiệm vụ Bất khả thi hay Scooby-Doo: một người đeo mặt nạ silicon của Ngoại trưởng Pháp – ông Jean-Yves Le Drian để làm video xin tiền các tỷ phú. Với cái cớ “viện trợ nước Pháp chuộc con tin”, kẻ lừa đảo đã nhận được tới cả chục triệu USD trước khi bị bắt.

Bằng một cái video mù mờ nhưng với lý lẽ thuyết phục, một người có thể thực hiện cú lừa triệu đô một cách dễ dàng. Giờ bạn hãy tưởng tượng một video rõ nét, với một khuôn mặt thân quen, mang theo những lời nói êm tai lên video, việc truyền đi thông điệp giả hay tiến hành lừa đảo sẽ dễ dàng ra sao.

Nhưng đây mới là mối lo ngại thực sự: công nghệ đã phát triển tới mức có thể ghép khẩu hình của kẻ lừa đảo vào với khuôn mặt của một cá nhân có tiếng.

Tôi đang nói tới video đi kèm công nghệ deepfake – những video có người phát ngôn là một gương mặt quen thuộc: có thể là người đứng đầu một quốc gia, một người có vai vế trong xã hội và rất được kính nể, có thể chính là người thân của bạn. Bằng một hình tượng đã rất thân quen với bạn, những lời phát ra từ miệng nhân vật đó sẽ bỗng dưng được nhân thêm tính thuyết phục. Bản chất của chúng ta đã thế rồi! Ta thân quen với những gì thân thuộc.

Giải thích về “deepfake”, công cụ lừa đảo thuộc hàng top của thời điểm hiện tại

Ban đầu, deepfake xuất hiện dưới dạng công cụ làm nội dung khiêu dâm cực kỳ tiên tiến, nhưng tiềm năng làm khuấy đảo an ninh trật tự thế giới của nó vẫn chưa được xem xét đúng mực.

Khi một kẻ bệnh hoạn muốn ngắm nhìn hình ảnh khỏa thân của một đối tượng bất kỳ, họ sẽ tìm tới những công cụ chỉnh sửa ảnh hoặc những người có hoa tay Photoshop. Nhưng khi hình ảnh chuyển động, Photoshop không đủ năng lực để thỏa mãn dục vọng kẻ đồi bại nữa…

… Cho đến khi sức mạnh machine learning và mạng neural xuất hiện. Với khả năng nhận dữ liệu đầu vào để phân tích, học các khuôn mẫu sẵn có rồi tự cho ra sản phẩm cuối cùng cực kỳ thuyết phục, nó trở thành công cụ tối tân nhất của ngành khiêu dâm.

Nó vượt xa các công cụ chỉnh sửa hình ảnh khi có thể làm ra được các video khiêu dâm, với khuôn mặt diễn viên đóng cảnh nóng ghép thành bất cứ cá nhân nào sở hữu một khuôn mặt ít nhiều điểm tương đồng. Công nghệ nổi tiếng đầu tiên trong khoản này là deepfake, với “deep” của từ “deep learning – học sâu” và “fake – đồ giả”.

Deepfake – Đồ giả kết hợp với sức mạnh của machine learning để biết thành hàng fake 1, thứ giống với hàng thật nhất và có chất lượng tương đối cao.

Đây là ví dụ về deepfake do đạo diễn phim Jordan Peel thực hiện. Video cũng là thông điệp nhắc nhở mọi người cảnh giác hơn trong thời đại số.

Hai video dưới chứng minh cho sức mạnh hiện tại của mạng neural, khi mà từ một tấm ảnh tĩnh, máy tính có thể làm ra video như thật. Cả hai đều là sản phẩm do ban nghiên cứu mạng neural của Samsung thực hiện.

Rasputin hát bài Halo.

Deepfake có thể làm gì?

Như đã nhiều lần cảnh báo, tin giả là hình thức phát tán thông tin cực kỳ nguy hiểm. Nhưng bằng chút nhận thức, bằng thái độ cẩn trọng hơn trong việc tiếp nhận thông tin, bằng 5 phút lên Google tra cứu, ta có thể tránh được việc bị tin giả dắt mũi.

Nhưng có mấy ai chịu khó tìm hiểu xem liệu những lời độc địa phát ra từ miệng nhân vật trong video là giả, dù rằng ban đầu chúng mang tính thuyết phục tới đâu. Từ lời nói cho tới cái miệng kia đều là giả: với lời nói là nội dung độc hại tới từ một người (hay một nhóm người vụ lợi cá nhân), cho tới video cũng được làm bằng máy tính.

Uncanny valley là thuật ngữ mô tả cảm giác của bạn khi nhìn vào tấm ảnh này. Trong ảnh là robot Sophia.

Ở thời điểm hiện tại, những video giả danh như vậy đều trông rất quái lạ. Nó mang lại cho bản cảm giác của uncanny valley – thung lũng kỳ lạ, cảm giác quái gở bạn cảm thấy khi nhìn vào một sản phẩm cực kỳ giống người, nhưng không hề mang lại cảm giác “giống người” chút nào. Hơn nữa, những điểm làm giả còn rất dễ nhận ra: khẩu hình của người nói lệch lạc ở nhiều điểm, có những điểm hình ảnh không ăn khớp với hình nền, do sức mạnh xử lý hình ảnh của máy tính vẫn chưa tới tầm chân thực.

Ta có thể làm gì?

Cho tới thời điểm này, có hai yếu tố khách quan khiến các video deepfake chưa gây nguy hiểm bằng đúng tiềm năng của nó, mới chỉ dừng lại ở “nội dung khiêu dâm”. Đó là:

– Công nghệ làm ra các nội dung này vẫn còn khá tốn kém. Mặc dù tốc độ làm giả đã được cải thiện đáng kể, tới mức đáng sợ.

– Các nhà nghiên cứu vẫn đang ra sức phát triển công cụ phát hiện ra nội dung giả mạo. Công nghệ có thể tạo ra được những thứ đáng ghê tởm đó, công nghệ cũng sẽ tìm được cách phát hiện và ngăn chặn nó lây lan.

Còn về mỗi cá nhân, chỉ có thể đưa ra lời khuyên về việc tỉnh táo khi dùng Internet, bên cạnh đó đừng chia sẻ và tương tác với những nội dung độc hại. Bạn đang giúp những kẻ đứng đằng sau thu lời bất chính và góp phần tăng tốc độ lây lan của thứ dịch bệnh mới mang tên deepfake.

Nguồn: Genk